职责分离的艺术:剖析主从Reactor模型如何实现极致的并发性能

Reactor工作者线程池模型 与单线程模型不同,工作者线程池模型引入了工作者线程池(Work Thread Pool),并将非I/O操作从Reactor线程中剥离,交由工作者线程池执行。这种设计能够显著提升Reactor线程的I/O响应速...

Reactor工作者线程池模型 与单线程模型不同,工作者线程池模型引入了工作者线程池(Work Thread Pool),并将非I/O操作从Reactor线程中剥离,交由工作者线程池执行。这种设计能够显著提升Reactor线程的I/O响应速...

作为程序员,看着这种概率与决策,感觉非常有趣,有时候常在想,能不能用程序模拟一下,选择哪个选择,我最终取胜的概率最大呢?

我们首先忽略网关,搭建一个grpc点对点服务调用。

前文,我们介绍了 字符(Character)、字形(Glyph)、字体的区别,这里我们再来实际分析一个字体文件中到底有什么,这有利于我们后续理解文字排版引擎的工作原理和流程。

原文: https://mp.weixin.qq.com/s/RUljlo23iM1XCVizwg4rog

这段履历算不上光鲜,却是大多数普通程序员经历的写照,还是有一定代表性的。这里就从一个普通程序员的角度,聊聊当前环境下,是否适合做编程。

后台每天都能收到粉丝类似的提问:“零基础想转测开,请问是先学 Java 还是 Python?”“公司要搭自动化框架,选哪种语言更靠谱?”

视差贴图在URP中通过动态UV偏移和高度图采样,有效平衡了性能与视觉效果。根据需求选择标准、陡峭或POM变种,可适配不同场景的细节要求

原理就是通过几张透明的png进行叠加,然后在上下滚动时,外层png移动的快,内层png移动得慢来实现视差效果。

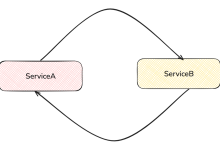

在上面这段代码中: 类 ServiceA 的实例需要注入 ServiceB 的实例。 类 ServiceB 的实例又需要注入 ServiceA 的实例。 这就形成了一个 ServiceA → ServiceB → ServiceA 的循环依...